Les notions d’intelligence artificielle et de machine learning ont envahi l’écosystème de la publicité digitale. Google et Facebook sont moteurs de cette tendance censée faciliter la vie des annonceurs.

La définition très fourre-tout conduit à une lecture complexe de l’utilisation de ces algorithmes.

Certains évoquent la disparition des métiers liés à la gestion des campagnes digitales. J’ai plutôt la conviction que les annonceurs vont rapidement déchanter sur la performance de leurs campagnes automatisées.

Ces plateformes disposent d’une quantité de données extrêmement puissante pour les annonceurs. Cependant, Google et Facebook imposent, à travers le ciblage large, une approche qui ne poursuit pas les intérêts des annonceurs mais bien leurs propres intérêts. Les annonceurs doivent donc en prendre conscience pour apprendre à utiliser les stratégies automatisées intelligemment.

Ce que les annonceurs peuvent obtenir des stratégies automatisées

Profiter d’une connaissance très précise des audiences

Grâce à l’omniprésence de leurs pixels, Facebook et Google mesurent tout de l’activité des internautes en ligne : sites visités, achats effectués, etc. Ces plateformes connaissent donc très bien les centres d’intérêt, les habitudes de consommation et l’évolution de la vie de chacun (mariage, déménagement, etc.),

Grâce à son moteur de recherche, Google en sait encore plus sur les besoins contextualisés et actualisés d’un individu. Force est de constater que Gmail et Whatsapp sont également sous le giron des deux géants de la pub.

Cette maîtrise des données des utilisateurs rend ces plateformes incontournables pour les annonceurs, dont les enjeux sont de cibler des audiences pertinentes pour leurs produits.

Cela suppose d’identifier des critères (âge, catégorie socioprofessionnelle, comportement en ligne, hobby, etc.) caractéristiques de ces audiences. Les plateformes publicitaires ayant une connaissance précise de leurs utilisateurs, elles sont capables de les identifier rapidement, avec une exhaustivité d’information bien supérieure à ce qu’un expert peut espérer lorsqu’il travaille manuellement.

Faire des stratégies automatisées les têtes chercheuses de son acquisition

Cette maîtrise des données confère aux stratégies automatisées une capacité inédite à lancer des campagnes rapidement et à collecter de l’information sur un nouveau marché.

Prenons l’exemple d’une entreprise qui souhaite s’ouvrir au marché espagnol et qui n’a aucune idée des requêtes tapées par les Espagnols sur Google pour son business.

Elle peut envisager une campagne automatisée avec des mots-clés larges pour découvrir les requêtes tapées ainsi que leurs volumes.

Cette logique vaut également pour tester un nouveau secteur.

Pour Facebook, il est intéressant de commencer par une audience large, car les annonceurs peuvent ainsi éviter de travailler selon des intuitions de départ qui pourraient les restreindre.

Cette approche expérimentale n’a pas vocation à durer éternellement et doit déboucher sur un apprentissage, comme détaillé ensuite.

Dis Google, gère mon budget marketing

Pour un annonceur, l’enjeu est également de définir un budget adéquat et de l’allouer pour tirer le maximum de son investissement publicitaire.

Google et Facebook recommandent désormais un ciblage large pour laisser leurs algos maximiser le potentiel de la campagne.

Poussons donc le raisonnement à l’extrême : nous cherchons à faire une campagne de conversions pendant un an sur Facebook sans connaître la typologie de la cible.

On laisse tourner un budget de 10€ par jour pendant un an avec un ciblage sur toute la France (audience très large de 35 000 000 personnes).

L’algorithme va diffuser les annonces à tout le monde puis l’algorithme de Facebook va progressivement identifier des profils qui réalisent la conversion souhaitée. Au fur et à mesure, la diffusion de la campagne va donc se concentrer sur ces profils.

On peut penser que les 3600€ ont été dépensés au mieux. Une alternative “manuelle” aurait nécessité de tâtonner. Si l’on ajoute la rémunération d’une personne chargée de cette tâche, on comprend quel intérêt un annonceur peut avoir à déléguer la gestion de ses campagnes payantes.

La présentation de ces avantages, poussées aujourd’hui par ces plateformes, s’inscrit dans une logique minimaliste, qui convient aux petits annonceurs.

Or, beaucoup d’annonceurs évoluent dans un marché concurrentiel et aspirent à faire de leurs campagnes, et plus généralement de leurs données marketing, un “game changer” de leur acquisition. Ces derniers sont les grands perdants d’une gestion déléguée.

De plus, dans le contexte actuel oligopolistique des GAFA, il n’est pas absurde de pousser la réflexion sur l’intérêt de confier aveuglément son budget marketing à Google ou Facebook.

Comprendre en quoi les annonceurs sont les perdants de cette tendance

L’enjeu de la saturation des inventaires performants

Google et Facebook doivent répondre aux demandes croissantes des annonceurs et les absorber dans un inventaire performant dont la croissance est limitée.

L’inventaire proposé aux annonceurs n’est pas homogène en termes d’efficacité. Le fil d’actualités a construit la réputation de Facebook auprès des annonceurs, en s’intégrant habilement dans l’expérience utilisateur. A l’inverse, la colonne de droite n’a jamais été un placement très performant.

On retrouve ces disparités dans l’inventaire de Google, notamment entre des requêtes très intentionnalistes et des requêtes informatives en search.

Si les meilleurs inventaires deviennent saturés, il y a un risque de :

- voir les prix exploser, ce qui menacerait la rentabilité des annonceurs

- dégrader l’expérience utilisateur avec des fils d’actualités ou des résultats de recherche saturés de publicités (ne serait-ce pas déjà le cas ?)

Leur défi est donc d’alléger la pression sur des inventaires très sollicités pour la répartir sur des inventaires moins performants ; si possible au même prix que sur les meilleurs.

Qui peut le plus peut le moins : surtout quand c’est l’annonceur qui régale

Le ciblage large, poussé par Google et Facebook, offre une réponse à cela. Il s’agit du point de rupture entre l’intérêt des annonceurs et celui des plateformes.

Le ciblage large, que sous-tendent les stratégies automatisées, pousse les annonceurs à lever le contrôle sur des ciblages qu’ils avaient l’habitude d’utiliser sur leurs campagnes via des exclusions ou de la segmentation.

Prenons, par exemple, le placement automatique sur Facebook, qui laisse à Facebook la latitude de répartir les annonces sur les placements de son choix.

Facebook diffuse majoritairement les annonces sur les fils d’actualités et les stories. Cependant, les annonces vont aussi être diffusées sur de l’interstitiel mobile sur des apps et des sites externes à Facebook, qui sont des placements nettement moins performants.

En Search, les possibilités de ciblage par mot-clé tendent à disparaître. C’est une façon habile pour Google d’exploiter son inventaire de requêtes informatives (“comment découper une orange”), exclues par beaucoup d’annonceurs. J’ai déjà développé cela dans un article spécifique sur le search.

Les annonceurs seront perdants en raison de placements de mauvaise qualité, voire indésirables, qu’ils risquent de payer au prix fort.

N’est-ce pas l’intérêt du digital que de choisir ce que l’on achète ?

Comment prévoir ce qui n’a jamais lieu ?

Les algorithmes ne peuvent pas prévoir ce qu’ils n’ont jamais vu.

Par conséquent, les annonceurs subissent des situations nouvelles sans pouvoir agir, entraînant une baisse d’efficacité de leur campagne le temps de l’apprentissage par les algos.

En effet, les stratégies automatisées fonctionnent sur la base de “patterns” récurrents pour construire des modèles prédictifs. Un pattern est, par exemple, le fait d’identifier une absence de conversions un certain jour de semaine.

Si ce comportement change, l’algo ne réagira pas immédiatement, et a besoin d’une certaine récurrence pour identifier ce nouveau comportement. Parfois il ne pourra pas l’identifier.

Or, beaucoup d’éléments non récurrents se produisent dans la vie d’un annonceur. Ces chocs peuvent être externes : ce fut le cas avec le Covid, mais aussi être internes : comme, par exemple, un problème d’ergonomie d’un site sur mobile. L’algorithme sera impacté et moins performant sur mobile. La difficulté est alors d’identifier rapidement ce problème.

Comment corriger si on ne sait pas ce qui fonctionne ?

Avec les stratégies automatisées, la performance est “moyennée” à travers une infinité d’optimisations faites par l’algorithme. Cela n’aide pas les annonceurs dans la compréhension de leur performance et donc dans la priorisation de leurs efforts.

La réussite ou l’échec d’une campagne s’explique par une infinité d’éléments, comme par exemple :

- La saisonnalité

- Un visuel ou un message impactant

- Une promo

- Un site efficace

Pour tirer des conclusions, il est important d’analyser les causes de succès à isopérimètre, c’est-à-dire sans être pollué par les autres causes. Ainsi, si la promo explique en grande partie la réussite d’une campagne, l’annonceur aurait tort de corriger le message de l’annonce.

Même si les plateformes remontent certaines recommandations (sur la qualité des annonces par exemple), comment savoir ce qui a le plus de poids ?

Pourquoi un annonceur plutôt que son concurrent ?

En optant pour des stratégies automatisées, les annonceurs oublient qu’ils n’ont pas de raisons d’être privilégiés par Google ou Facebook face à leurs concurrents.

Cette réflexion est particulièrement importante en Search où le nombre d’annonceurs sur un mot-clé donné est limité. La plupart poursuivent des objectifs similaires. Alors si tous les annonceurs sont en stratégies automatisées, et face à un utilisateur “chaud” pourquoi Google pousserait-il davantage un annonceur plutôt que son concurrent ?

Pour Facebook, Display ou YouTube, l’annonceur évolue face à une infinité d’annonceurs et non uniquement face à ses concurrents.

Cependant, on peut tout de même s’interroger sur le critère de décision qui pousse l’algorithme de Facebook à choisir un annonceur plutôt qu’un autre.

Si ce critère est le prix, alors on revient à une logique manuelle.

Dépenser trop ou manquer des opportunités

Beaucoup d’annonceurs ont une approche agnostique des campagnes menées. Ils placent un budget et attendent ensuite de voir les résultats. Lorsque la performance est au rendez-vous, ils augmentent les dépenses.

La limite de cette approche est d’une part de dépendre de Google ou Facebook et d’autre part de ne pas mettre le budget adéquat selon les moments.

Avec les stratégies automatisées, il est rare de ne pas dépenser le budget placé. Ne comptez donc pas sur Google ou Facebook pour aider l’annonceur à définir le bon budget.

Les recommandations, notamment chez Google, poussent généralement les annonceurs à augmenter leurs budgets même lorsque les objectifs ne sont pas toujours atteints.

Par conséquent, le risque pour les annonceurs est de s’adapter ni à leur marché ni à l’investissement requis.

Ne pas adopter le bon message

Grâce au digital, les annonceurs ont la possibilité d’adapter leur message de communication selon leurs cibles.

Le ciblage large rend bien évidemment difficile cette pratique, qui fait toute la richesse du digital.

Les data scientists de Google et Facebook ne bossent pas pour vous, annonceurs !

Enfin pour conclure, il est important de rappeler que les data scientists qui ont bâti ces algos ne travaillent pas pour les annonceurs, mais pour Google ou Facebook.

D’un point de vue utilisateur, nous mesurons peu à peu les effets pervers de ce que leurs ingénieurs ont bâti pour générer à tout prix du partage et de l’interaction. Les annonceurs auraient tort d’être aussi naïfs sur la visée première de ces plateformes.

Les bonnes pratiques à suivre pour garder un certain contrôle

Sortir des reportings d’attribution de Facebook et Google

Aujourd’hui, beaucoup d’annonceurs sont convaincus de l’efficacité des algorithmes de Google et Facebook car les campagnes atteignent leurs objectifs. Pourtant, trop peu sont conscients du poids excessif que s’attribuent ces plateformes dans les conversions obtenues, puisqu’elles font elles-mêmes le reporting. Coach et arbitre, en somme.

De plus, grâce à un tracking omniprésent, Google et Facebook s’insèrent très facilement dans le parcours de conversion d’un individu, notamment grâce au remarketing.

Leur poids est donc anormalement élevé dans les modèles d’attribution des annonceurs outrepassant notoriété et bouche-à-oreille. C’est précisément ce qui explique l’effroi que suscite chez Facebook la fin du tracking sur iOS14.

Il y a donc une urgence pour les annonceurs à comprendre leur tracking et leur attribution pour mesurer la vraie valeur ajoutée de leurs campagnes.

Des solutions indépendantes type Eulerian, ou encore des outils type Segment peuvent permettre de reconstruire le parcours des visiteurs. C’est le même fonctionnement que Google Analytics mais avec de la neutralité.

A défaut, je recommande aux annonceurs de valoriser le First Clic, qui a au moins le mérite de donner du poids au trafic nouveau.

Ne pas créer des campagnes fourre-tout

Il est dans l’intérêt des annonceurs d’éviter tant que possible le ciblage large avec le risque de créer des campagnes fourre-tout.

Les campagnes des annonceurs doivent rester homogènes et segmentées même avec les stratégies automatisées.

En Search, les campagnes doivent réunir des mots-clés avec un niveau d’intentionnalité similaire, et ainsi éviter de mélanger des requêtes informatives et des requêtes intentionnalistes.

J’utilise généralement des stratégies automatisées pour bénéficier d’un apprentissage continue en dehors du « cœur de business” pour lequel je privilégie une approche plus manuelle. Cela évite de perturber la partie majeure de l’acquisition avec la partie “apprentissage”, dont le budget peut ainsi rester expérimental.

Sur Facebook, plutôt que de travailler sur une seule très grosse audience, il est préférable de cibler plusieurs audiences de taille intermédiaire (500 000 personnes). Facebook optimise ensuite la répartition du budget entre les sous-ensembles de publicités.

Ainsi construites, les campagnes gardent une cohérence dans leurs objectifs et les performances sont davantage exploitables.

Segmenter les audiences et éviter la cannibalisation

Le schéma ci-dessus illustre comment un annonceur peut penser sa profondeur de marché ; chaque niveau représentant une audience de moins en moins chaude.

L’idée pour les annonceurs est d’avoir un ordre de grandeur de ces strates, sur lesquelles des budgets et des objectifs sont ensuite déployés.

Dans cette optique, la segmentation des audiences au sein des campagnes est une bonne pratique. Cependant, elle est loin d’être évidente aussi bien avec Facebook que Google, car le chevauchement des audiences est délicat à gérer.

Or, lorsque deux ensembles se superposent, il est impossible de comparer leur performance et donc de tirer des conclusions.

Google recommande, par exemple, de placer plusieurs audiences en observation. Mais comme un individu peut se trouver dans plusieurs audiences à la fois (“Intéressé par les outils marketing”, “Voyages et Loisirs”, etc.) comment savoir dans quelle audience Google a décidé de le placer ?

On retrouve cette tendance à mixer les audiences chez Facebook, notamment avec les audiences des visiteurs (remarketing).

Les annonceurs peuvent déjà commencer par l’approche la plus basique possible : exclure les audiences de remarketing de toutes les campagnes qui n’ont pas vocation à l’être pour distinguer le trafic “nouveau” du trafic “réchauffé”.

Ne pas faire d’A/B tests

Beaucoup d’annonceurs mènent des A/B tests pour comparer la performance des stratégies automatisées à celle des stratégies manuelles.

Si les deux versions du test sont en concurrence, notamment en Search, l’annonceur ne pourra tirer aucun enseignement.

En effet, le comportement sur 50% du budget n’est pas comparable avec celui sur 100%, car l’efficacité d’une campagne doit justement être mesurée relativement à sa capacité à gérer la taille du marché.

Il est préférable d’analyser la performance sur deux périodes suffisamment longues et comparables.

Eviter de travailler en coût d’acquisition cible (CPA)

Les annonceurs sont forcément perdants en utilisant des stratégies automatisées en CPA cible car ils risquent soit de bloquer leurs campagnes avec un CPA trop bas, soit de surpayer le prix de leurs conversions.

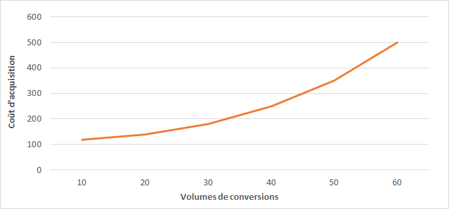

En effet, le coût d’acquisition est fonction des volumes de conversions.

Toutes choses égales par ailleurs, plus on veut de conversions, plus le coût d’acquisition augmente :

Travailler en CPA cible nécessite de connaître précisément le coût d’acquisition par palier (ou strate).

Par conséquent, un annonceur a de grandes chances de ne pas “pricer” correctement son CPA cible, le ciblage large des campagnes n’aidant en rien.

Cette stratégie est rassurante pour un annonceur car elle lui donne l’impression de payer le bon prix. Mais, ce n’est pas le cas.

C’est pourquoi je considère que les stratégies automatisées doivent essentiellement permettre de maximiser les volumes de conversions. Ce qui revient à trouver le coût d’acquisition le plus bas pour un budget donné.

Conclusion

Google et Facebook ont créé des opportunités incroyables pour de nombreux business, qui ont pu se lancer sans déployer les budgets publicitaires requis dans les univers de la pub et de la télé. Leurs inventaires restent très précieux pour les annonceurs.

En revanche, ces derniers doivent pouvoir comprendre ce qu’ils achètent en digital et n’ont pas à supporter les contraintes rencontrées par ces plateformes. Les annonceurs méritent également une plus grande transparence dans les recommandations poussées par ces plateformes.

L’utilisation des algorithmes de Google ou Facebook n’est pas un débat sur la performance de l’homme contre celle de la machine, puisque les objectifs poursuivis dans chacun des cas ne sont pas les mêmes.

Il s’agit d’un débat sur l’ambition des annonceurs car le marketing digital offre une chance unique aux entreprises d’être acteur de leur marketing. C’est ce que j’ai appris pendant toutes mes années dans le digital ; Google et Facebook ayant été les grands évangélisateurs de cette idée.